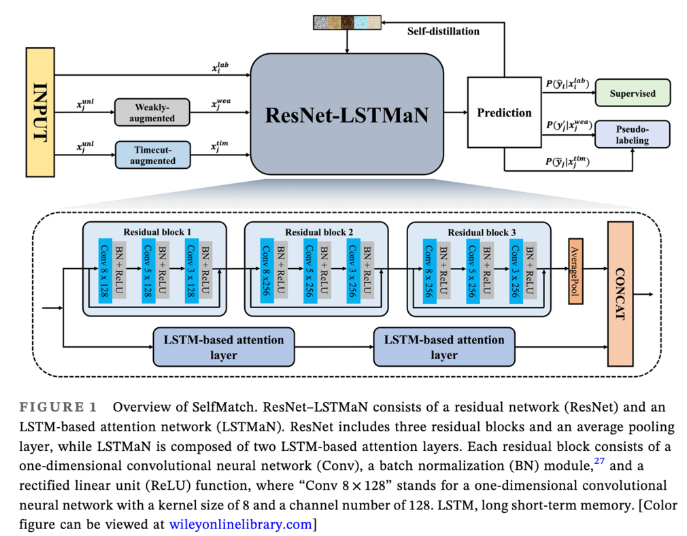

Abstract SelfMatch (이 논문에서 제시한 모델 !!) 목적: 시계열 분류 (TSC) TSC를 위한 특징 추출기인 ResNet–LSTMaN을 설계하여 특징 및 관계 추출을 담당 방법: supervised + unsupervised + self distillation unsupervised: (pseudo labeling 적용) label data에 대한 feature extract (레이블이 지정된 데이터와 지정되지 않은 데이터 간의 연결을 탐색) 약하게 증가된 시퀀스는 같은 시퀀스의 Timecut-증가된 버전의 예측을 안내하는 목표 (= 어떤 데이터 시퀀스의 변화를 이해하고 이를 기반으로 미래의 변화를 예측) self distillation: 높은 수준에서 낮은 수준으로의 지식흐름 → 낮은..