0. Abstract

- Unsupervised Continual Learning

- 우리는 학습된 특성 표현을 분석하는 체계적인 연구를 수행하고, 비약적인 잊혀짐(catastrophic forgetting)에 대한 더 뛰어난 내구성을 갖고 일관되게 더 나은 성능을 달성하며, 분포 외 작업에 대해 더 나은 일반화를 시키는 것을 보여줍니다.

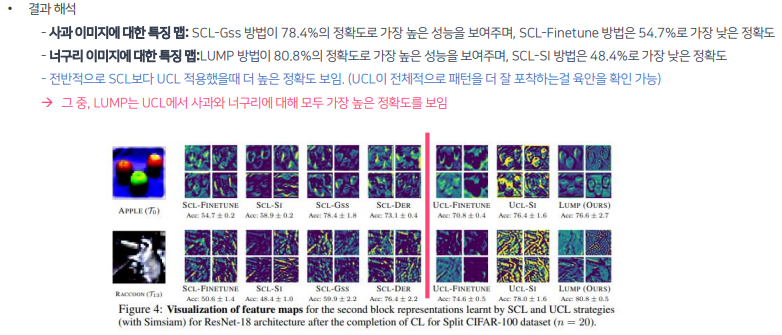

- Lifelong Unsupervised Mixup (LUMP)

- 간단하지만 효과적인 기술을 제안하며 현재 작업과 이전 작업의 인스턴스 사이를 보간하여 비약적인 잊혀짐을 완화

1. Introduction

- UCL 구현 방법

- 기존의 SCL 전략을 비지도 지속 학습 프레임워크로 확장하고 현재의 최첨단 표현 학습 기술인 SimSiam (Chen & He, 2021)과 BarlowTwins (Zbontar et al., 2021)를 UCL에 대한 성능을 분석

- 비지도 표현의 견고성 확인 방법

- 독립적인 UCL 및 SCL 모델 간 및 UCL 및 SCL 모델 간에 중심 커널 정렬 (Centered Kernel Alignment, CKA)을 측정하여 특성 유사성을 조사

- contribution

- 우리는 지속적인 학습과 표현 학습 간의 간극을 줄이고 레이블이 없는 데이터와 일련의 작업에서의 표현 학습의 두 가지 중요한 문제에 대한 해결책을 시도했습니다.

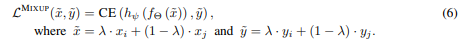

- 체계적인 정량적 분석은 UCL이 Sequential CIFAR-10, CIFAR-100 및 Tiny-ImageNet에서 더 낮은 catastrophic forgetting과 함께 더 나은 성능을 달성한다는 것을 보여줍니다. 또한 분포 외 작업 및 소수의 예제 교육을 평가하여 비지도 표현의 표현력을 보여줍니다.

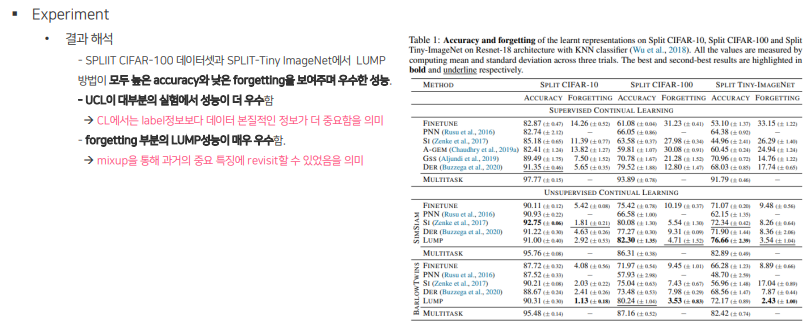

- 우리는 표현과 손실 랜드스케이프의 시각화를 제공하며, UCL이 구별력 있는 인간의 지각적 패턴을 학습하고 더 평탄하고 부드러운 손실 랜드스케이프를 달성한다는 것을 보였습니다. 더불어, 우리는 UCL을 위한 Lifelong Unsupervised Mixup (LUMP)를 제안하였고 이것이 catastrophic forgetting을 효과적으로 완화하고 더 나은 질적 해석을 제공한다는 것을 보였습니다.

2. Related work

생략

3. Preliminaries

3.1. Problem Setup

3.2. Learning Protocol And Evaluation metrics

4 Unsupervised Conitnulal Learning

4.1 Continuous Representation Learning with Sequential tasks

- SimSiam, BarlowTwins 사용

- 큰배치, 음성 샘플쌍, 아키텍처 수정, 미분 가능하지 않은 연산자 필요X

SimSiam.

- 의미 해석

- projector를 통한 output vector와 하나의 이미지에 대한 2개의 augmentation predictor 간의 코사인 유사도 계산

- stopgrad

- crucial component in SimSiam to prevent the trivial solutions obtained by Siamese networks

BarlowTwins.

- 기능

- 인스턴스의 왜곡된 버전의 임베딩 벡터 구성 요소 간의 중복성 최소화 + 최대 정보 보존

- 의미 해석

- 두 개의 동일한 네트워크의 출력 간에 계산된 교차 상관 행렬을 항등 행렬에 가깝게

- 두 개의 Siamese 브랜치의 출력 사이의 배치 차원을 따라 교차 상관 행렬을 C로 표시

- Z1과 Z2는 현재 작업의 배치에서 모든 이미지에 대한 왜곡된 뷰의 배치 임베딩 (xτ ∈ Uτ ).

⇒ 간단하며 구현이 쉽고, 거의 수정 없이 기존의 지속적 학습 전략에 적용가능.

4.2 Preserving Representational Continuity: A view of existing SCL methods

4.3 Lifelong unsupervised mixup

5. Experiments

Comments

1. LUMP 실험조건이 어떻게 되는가?

- supervised와 unsupervised의 실험 조건이 동일한가?

2. LUMP에서 학습을 처음할 때, 이전 데이터가 없는데 어떻게 학습하는가?

3. replay buffer가 계속 축적되면 메모리 사이즈가 계속 증가하게 되고, 이후엔 결론적으로 기존 batch learning과 다를 바 없이 catastrophic forgetting 문제가 발생하지 않는가?